Auch innovative KI-Modelle allein können nichts ohne die richtigen Trainingsdaten – und produktive Trainer.

Active Learning = No Pain, No Gain? Programmierung nicht mehr notwendig, aber Training schon.

Das inserve-Team hat bereits das Ziel erreicht, in der eigenen Intelligent Document Processing-Plattform nahezu alle notwendigen Verarbeitungsschritte durch lernfähige KI-Bausteine abzudecken (z.B. Stapeltrennung, Dokumentenklassifizierung, Informationsextraktion). Dies senkt den Aufwand und steigert die Anpassungsfähigkeit für die Automatisierung massiv.

Darüber hinaus sind Möglichkeiten entstanden, die vorher nicht durch Programmierung und schon gar nicht manuell umsetzbar waren, wie z.B. das Finden möglichst homogener Cluster in hunderttausenden Seiten. Diese funktionieren sogar ungestützt (ohne Labels/Auszeichnungen).

Für einige Schritte ist aber natürlich ein Training durch menschliche Spezialisten notwendig. Auch wenn Trainingsbedarf und Leistung der KI-Modelle bereits optimiert sind, so muss der Trainingsprozess dennoch möglichst effizient gestaltet sein:

- Wie können möglichst informative Trainingsbeispiele identifiziert werden?

- Wie können unbalancierte Verteilungen (auf viele Klassen) abgedeckt werden?

- Wie kann der Anwender möglichst komfortabel durch den Trainingsprozess geführt werden?

- Woher weiß der Anwender, wie gut das von ihm trainierte Modell bereits generalisiert?

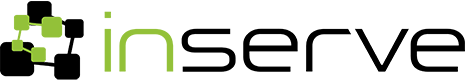

Human in the Loop & Konfidenz

Das Human-in-the-Loop-Prinzip bietet hierfür den richtigen Rahmen, indem es die Konfidenz der Vorhersagen der KI-Modelle nutzt, um sowohl beim initialen Training als auch im laufenden, produktiven Einsatz unsichere Vorhersagen auszusondern und sich beim menschlichen Spezialisten rückzuversichern. Active Learning treibt dieses Prinzip auf die Spitze, indem es den Anwender automatisiert durch das Training leitet.

Möglichst wenige, aber zielführende Trainingsbeispiele für Active Learning

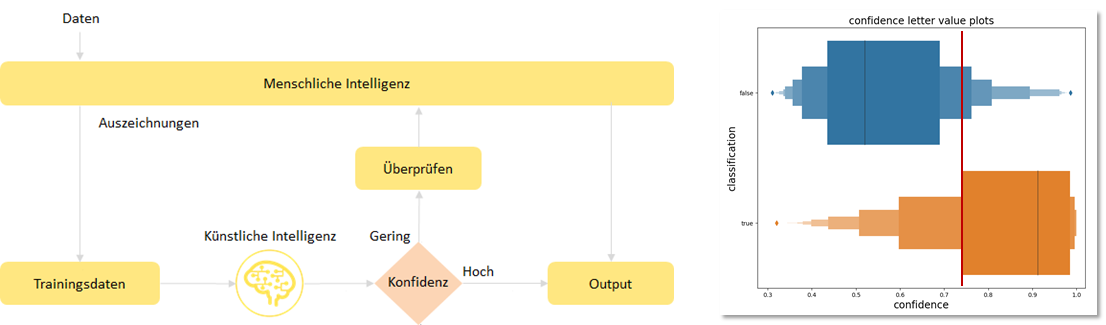

Die Grundidee von Active Learning besteht aus folgendem, iterativen Ansatz:

- Finde eine überschaubare Menge möglichst informativer Trainingsbeispiele.

- Erlaube dem Anwender, diese möglichst einfach und zügig auszuzeichnen.

- Trainiere das KI-Modell vollständig neu oder inkrementell.

- Entscheide – automatisiert oder durch den Anwender – ob das Training ausreichend ist.

- Wenn nicht – beginne wieder bei Eins (s.o).

Active Learning Ablauf (vereinfacht)

Eigentlich relativ einfach, aber ein paar Tücken sind im Detail dennoch zu lösen:

Was sind möglichst informative Beispiele?

Wie immer gibt es in Forschung und Literatur verschiedene Ansätze, die mehr oder weniger intuitiv nachvollziehbar sind und teilweise miteinander kombiniert werden:

- Konfidenz-basiert: Bei welchen Beispielen ist sich das Modell am unsichersten?

- Komittee-basiert: Bei welchen Beispielen sind sich verschiedene Modelle am wenigsten einig?

- Dichte-basiert: In welchen Regionen des Datenraums sind bisher die wenigsten Beispiele vorhanden?

- Diversitäts-basiert: Welche Datenpunkte unterscheiden sich am stärksten von den schon vorhandenen?

- Veränderungs-basiert: Wo verändert sich das Modell am stärksten?

- Lerner-basiert: Ein weiteres Modell schätzt, welche Beispiele die größte Leistungssteigerung bringen.

Da aber bei allen faszinierenden Ideen immer die Praxisnähe im Sinne von Verarbeitungsgeschwindigkeit und echten, messbaren Vorteilen im Blick behalten werden muss, ist Sorgfalt bei Auswahl und Umsetzung geboten.

Wie schnell ist die technische Verarbeitung?

Einerseits muss der Ablauf für den Anwender möglichst zügig sein, anderseits kosten alle genannten Schritte Verarbeitungszeit: Die Auswahl (das Sampling) muss hinreichend viele Datenpunkte überprüfen und danach besonders informative auswählen. Je nach Modell kann inkrementell oder muss vollständig neu trainiert werden, je komplexer dies ist, desto mehr Zeit ist erforderlich.

Wie sieht die optimale Interaktion für den Anwender aus?

Idealerweise legt die Anwendung automatisch nacheinander die ausgewählten Beispiele vor und zwar so, dass der Trainer diese möglichst gut bewerten und die korrekte Auszeichnung möglichst ergonomisch vornehmen kann. Die optimale Interaktion variiert stark mit der jeweiligen Aufgabenstellung – Klassifizierung von Dokumenten oder Informationen auf einer Seite, Trennung von Stapeln, Erkennen von Entitäten.

Wann wurde genug trainiert?

Beim Active Learning muss der Anwender (oder das System) bewerten können, wann in Bezug auf die Gesamtheit der Daten (Dokumentenbestände oder ‑ströme) das Training ausreichend gut erscheint oder die Effizienz (Anzahl der Trainingsbeispiele in Relation zur Verbesserung) zu stark sinkt.

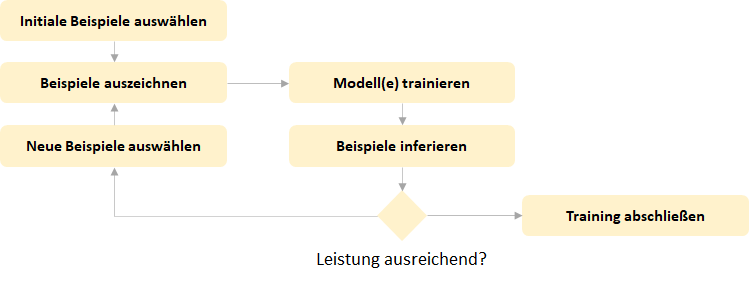

Konkretes Praxisbeispiel: Klassifizierung von Dokumenten

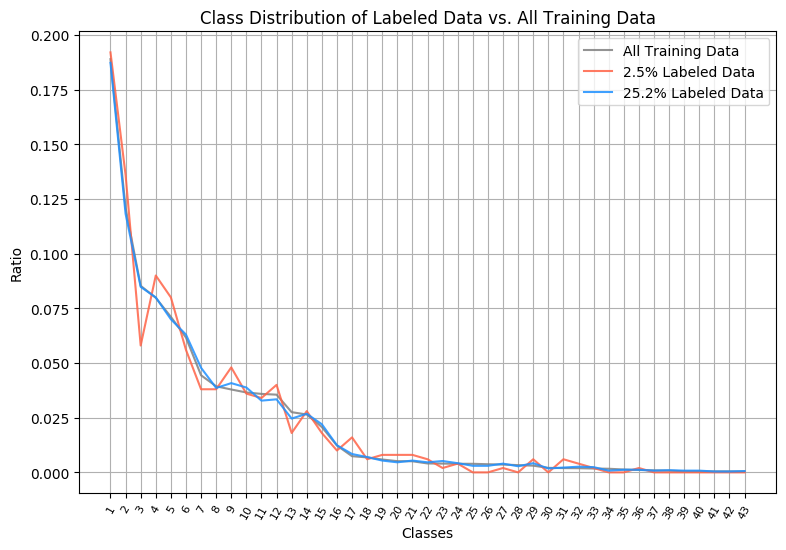

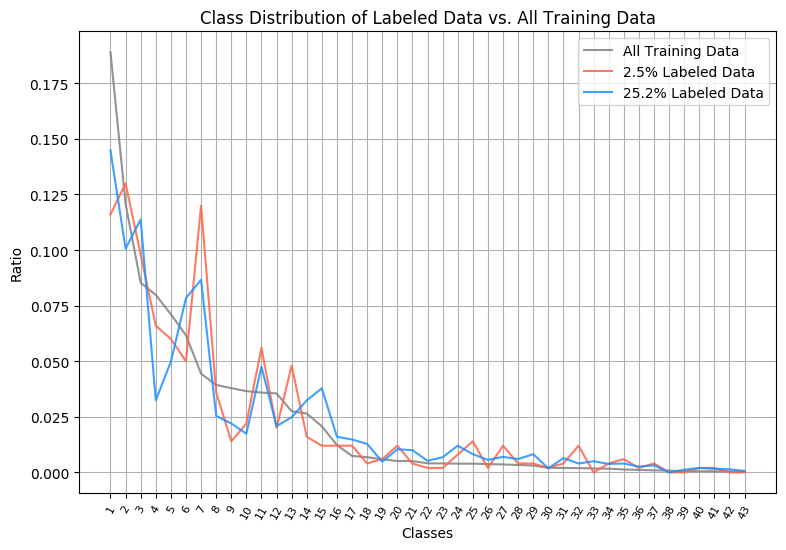

Zur Verdeutlichung haben wir bewusst einen Dokumentenbestand mit vielen (43), sehr unbalancierten und teilweise schwer zu unterscheidenden Geschäftsvorgängen (Klassen) gewählt. Verschiedene maximale Anteile der Dokumente wurden für das Training (80÷20) und der Rest als fixe Validierungsdaten verwendet. Diese sind bereits ausgezeichnet, in der Active Learning Simulation werden aber nur jeweils die pro Iteration ausgewählten Beispiele für das Training verwendet.

Schnellere Trainingserfolge

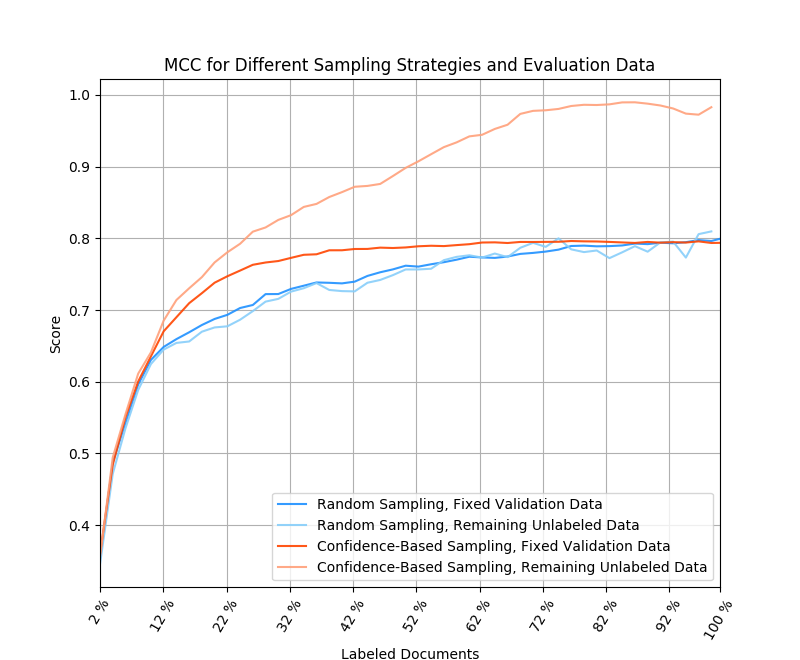

Entwicklung MCC für max. 80% / 20% Trainingsdaten und verschiedene Sampling Strategien

Als Vergleichsreferenz wurde das rein zufallsbasierte Sampling mit einer Konfidenz-basierten Strategie anhand der Primärmetrik MCC verglichen. Dabei wurde einmal auf den jeweils nicht vom Trainer ausgezeichneten Daten aus dem Trainingsbestand („remaining“) und einmal auf dem fixen Validierungsbestand gemessen.

In allen Fällen ist die Leistung des Konfidenz-basierten Samplings etwas bis deutlich besser. Vor allem aber wird die maximal erreichbare Leistung deutlich früher angenähert. In der Praxis bedeutet dies wesentlich schnellere Trainingserfolge!

Wann wurde genug trainiert?

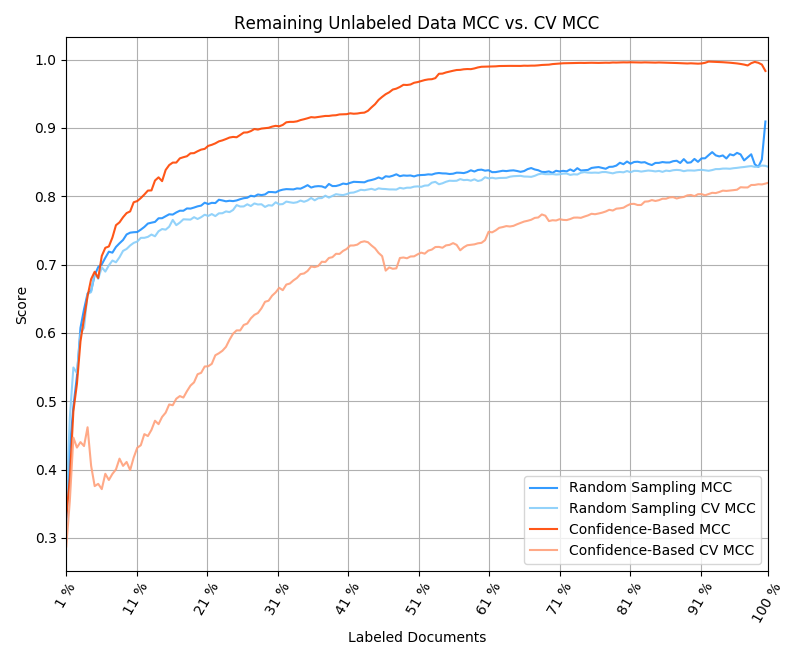

In der Realität liegen natürlich nicht alle Daten mit Auszeichnungen vor, es kann jedoch eine Cross Validation auf den verfügbaren Trainingsdaten zur Einschätzung der erreichten Leistung genutzt werden.

Vergleich tatsächliche mit messbarer Leistung

Diese Visualisierung zeigt, dass der Cross Validation (CV) MCC die tatsächliche Leistung der Konfidenz-Strategie im Trainingsfortschritt fast durchgängig systematisch unterschätzt (dies konnten wir für alle o.g. Varianten beobachten). Intuitiv ist dies auch nachvollziehbar, da diese Strategie für jede Iteration die Beispiele mit den unsichersten Vorhersagen auswählt.

Dies kann über die Betrachtung der Steigerung der Modellleistung, über zusätzliche zufallsbasiert ausgewählte Beispiele oder die Entwicklung der Konfidenz bzw. eine Kombination dieser Ansätze gelöst werden.

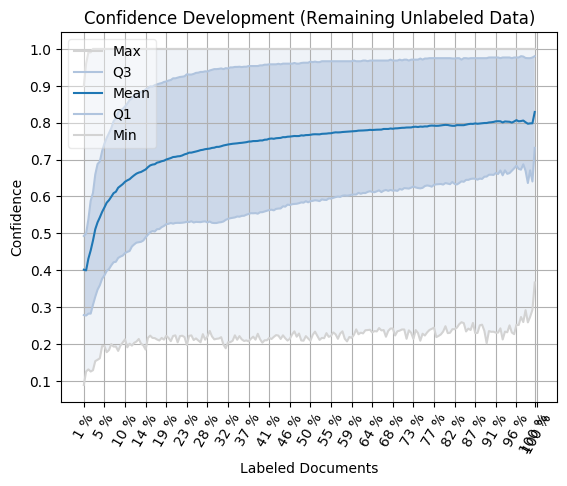

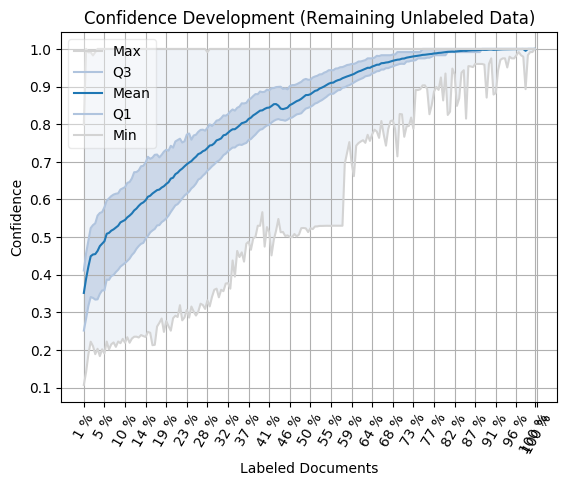

Höhere Konfidenz und andere Verteilung

Interessant sind zu guter Letzt noch zwei Aspekte:

Naturgemäß steigt die Konfidenz in den vom Trainer nicht gesehen Dokumenten eines fixen Bestandes deutlich schneller und höher:

Vergleich der Konfidenzentwicklung auf ungesehenen Daten (Zufall/Konfidenz)

Weiterhin ergibt sich auch eine andere Verteilung auf die Klassen: Bei den höher frequenten wird differenzierter ausgewählt und die niederfrequenten haben (soweit möglich) einen systematisch höheren Anteil:

Vergleich Klassenverteilung bei unterschiedlichem Trainingsfortschritt (Zufall/Konfidenz)

Schlussfolgerungen

Human-in-the-Loop-Prinzip und Active Learning zeigen einmal mehr, dass die reine Fokussierung auf (komplexe) KI-Modelle für die Anwendungspraxis nicht immer Sinn macht. Entscheidend ist die Integration in ein Gesamtkonzept u.a. aus effizienten Trainingsmechanismen, ergonomischen Benutzeroberflächen und skalierbarer, performanter Ausführung von Training und Inferenzen.

Das inserve-Team integriert daher aktuell Active Learning-Konzepte in seine Plattform, um deren Mehrwerte und Wettbewerbsvorteile bei der Verarbeitung komplexer Dokumentenbestände und ‑ströme weiter auszubauen.

Der Artikel wurde von den Experten Arvin Arora und Yan-Frederic Thorsting verfasst.

Haben Sie Interesse an einer Vertiefung des Themas Active Learning oder der Nutzung der inserve-Plattform?

Direkt Termin vereinbaren!

Mit dem Online-Tool Calendly können Sie direkt online Ihren Wunschtermin wählen. Buchen Sie noch heute Ihre 15-minütige Besprechung bei Dietmar Neidig und erhalten Sie eine Kalender-Einladung mit Zugangslink zu Ihrer persönlichen Teams-Besprechung.